前回(第3回)は、大規模言語モデル(LLM)の構造や、プロンプトによってAIの応答が容易に書き換えられてしまう仕組みを解説しました。AIが自然言語の指示を柔軟に処理できるがゆえに起きる脆弱性は、多くの企業・組織にとって今後無視できないリスクとなるでしょう。

今回(第4回)は「対策編」として、プロンプトインジェクションを防ぐための具体的な手法やベストプラクティスを紹介していきます。技術的な実装例から運用上のポイントまで、幅広い視点から対策を整理しますので、ぜひご参考にしてください。

連載記事のご案内

本記事は、プロンプトインジェクションの導入から実践的な対策までを紹介するための連載企画「AI時代の新たな脅威を防げ!プロンプトインジェクション対策最前線」の第4回です。以下の各回もあわせてぜひお読みください。

- 第1回:導入編「プロンプトインジェクションとは?仕組みと危険性をわかりやすく解説」

- 第2回:事例編「実際に起きた攻撃手法と被害例を深掘り解説」

- 第3回:技術編「LLMの仕組みから見るプロンプトインジェクションの脆弱性」

- 第4回:対策編「プロンプトインジェクションを防ぐベストプラクティスと実践ポイント」

- 第5回:運用・管理編「ビジネスで取り入れる際の注意点と組織的な体制づくり」

- 第6回:今後編「プロンプトインジェクションの未来と進化、そして私たちに求められるアクション」

- 第7回:特別編「攻撃プロンプト&防御テクニックまとめ」

プロンプトインジェクション対策の基本をおさえる

ここではまず、プロンプトインジェクションを防ぐうえで意識しておきたい基本的な考え方を解説します。AI活用を行う際に、どのようなフレームワークやマインドセットでセキュリティを考えるべきか理解しましょう。

セキュリティの三層アプローチ

対策を検討する際には、以下のような3層構造でセキュリティを捉えると整理しやすくなります。

- 入力(Prompt)対策:ユーザーやシステムがAIに送るテキストの管理

- モデル(LLM)側の制御:ポリシー設定やコンテクスト制御

- 出力(Response)フィルタリング:AIの回答を最終的に検証・制限する仕組み

たとえば「入力バリデーションだけ行えばOK」とはならず、AIの内部処理や出力段階でもガードをかけることで、多層的な防御が可能になります。

「外部リソースに依存しない」原則

プロンプトインジェクション対策をする際は、AIの応答に過度に依存しない運用設計が重要です。極端な例として、「AIの提案をそのまま実行すればすべてがうまくいく」といったシステム設計だと、万一不正な応答があったときに大きな被害を被る可能性があります。

- 例: AI出力をそのままファイルシステムやデータベースに書き込まない

- 例: 人間による承認フローを挟む

AIの回答は常に“仮説”または“提案”と捉え、人間や別の検証プロセスが最終判断を担う設計にしておくのが基本です。

入力(Prompt)対策

プロンプトインジェクションは、悪意ある指示や不正な上書き命令がAIに届いてしまうことで成立します。ここでは、どのように入力を安全に保つかを中心に具体例を挙げて説明します。

入力バリデーションとサニタイズ

Webセキュリティで一般的な「入力チェック」と「サニタイズ」は、生成AIの世界でも一定の効果を発揮します。

- 入力チェック(Validation): ユーザーが入力したテキストにNGワードや過度な長さはないか、制御文字が混在していないかなどを検証し、問題があればブロックする。

- サニタイズ(Sanitization): HTMLタグや特殊文字を無害化する。自然言語プロンプトの場合は効果が限定的な面もありますが、「プログラムコードの一部が入力されている場合にそれを無効化する」などの方法で一定の防御になります。

コンテクスト分離(Context Isolation)

コンテクスト分離とは、AIが参照する文脈をユーザーごとに、またはシーンごとに明確に区切るアプローチです。たとえば、Aさんの会話内容がBさんの会話内容に影響しないようにしたり、過去のやり取りでも機密性の高い話題は簡単に参照できないようにしたりといった工夫が挙げられます。

- メリット: 攻撃者が連鎖的に情報を引き出す難易度が上がる

- 方法: セッションIDを厳格に管理し、特定のID以外は機密情報にアクセスできないようにするなど

Role-based Prompting(役割指示)

AIの応答方針を「ユーザープロンプト任せ」にするのではなく、明示的に役割を指定して安全性を担保する方法です。

- 例: 「あなたは企業のカスタマーサポート担当です。顧客情報を開示する権限は持っていません」という指示を事前に与えておく

- ポイント: ユーザーが「権限を上書きする」ようなプロンプトを送ったとしても、システムが優先するルールとしてロール設定を固定することで、ある程度ブロック可能になる

モデル(LLM)側の制御

AIモデルそのもの、あるいはアプリケーション層のポリシーでプロンプトインジェクションを防止する仕組みを考えることも重要です。ここでは、LLMを正しく制御するための方法を見ていきましょう。

システムメッセージの優先度設定

ChatGPTなど一部のLLMフレームワークでは、ユーザーからの入力とは別に「システムメッセージ」や「開発者メッセージ」といった特権的なプロンプトを設定できます。

- 効果: システムメッセージを常に最優先で適用することで、ユーザーの悪意あるプロンプトを上書きしようとしても簡単には突破できなくなる

- 注意点: 完全に防ぎきれない場合があるため、他の対策と併用が望ましい

ガードレール(Guardrails)による自動検知

ガードレール(Guardrails)は、生成AIが出力するテキストをリアルタイムに監視し、意図しない出力を検出・修正・ブロックするための仕組みを指すことがあります。

- 例: 自動でポリシー違反を判定し、“機密情報を提供しようとしている”場合は警告を出す

- ツール例: 一部のLLMプラットフォームやセキュリティツールでは、ガードレールの初期実装が提供されている

パラメータチューニングと微調整

AIモデルの出力を制御するうえで、テンプレートやパラメータの設定を適切に行うことも有効です。

- 例: 出力の「温度(Temperature)」パラメータを低く設定することで、過激な推論を抑え、リスクの高い出力が出にくいようにする

- メリット: 不正な内容を“生成しにくい”方向にモデル特性を調整できる

- 注意: ゼロにはできないので、他のセキュリティ策との組み合わせが必須

出力(Response)フィルタリング

AIが返す答えを、ユーザーに見せたりシステムが実行したりする前に最終チェックを行う方法です。入力からモデルまでの制御でカバーしきれなかった場合でも、出力フィルタリングが最後の砦となることがあります。

自然言語処理ベースのコンテンツ検閲

再度、AIやルールエンジンを用いて、生成された文章が安全なものかどうかを判定する手法です。

- 例: 「これは機密情報を含む可能性が高い」と判定された場合、出力を差し止める

- ポイント: 自然言語に対するフィルタリングは曖昧さがあるため、精度向上のための継続的なチューニングが不可欠

ヒトのレビュー・承認フロー

最終段階で人間がレビューし、問題がないかを確認してから外部公開や実行を行う仕組みです。

- メリット: AIが見逃す微妙なケースでも、人間が目視で発見できる可能性がある

- デメリット: 大量の出力を取り扱う場合は工数増大につながるため、自動化とのバランスが重要

運用上の注意点

技術的な対策を実装するだけでなく、実際に運用するうえで押さえておくべきポイントも紹介します。ここでは主に組織的なルール設定やユーザー教育に焦点を当てます。

セキュリティポリシーとガイドラインの整備

- ポリシー例: 「機密情報をAIに入力するときは暗号化プロセスを挟む」「顧客データを扱う際には必ず責任者の承認を得る」など

- ガイドライン: ユーザーが誤ってプロンプトインジェクションを誘発しないよう、注意喚起や入力方法のベストプラクティスをまとめる

教育・トレーニングの実施

- 内部研修: プロンプトインジェクションの概念や、どんな行為がリスクを高めるのかを学んでもらう

- エンドユーザー向けガイド: 一般社員や顧客に対しても「AIへの入力は慎重に行うこと」「疑わしい操作をするときはサポートに相談する」などの周知を徹底

継続的なモニタリングとアップデート

- ログ監視: AIの対話ログや出力結果を定期的にレビューし、不審なパターンがないかチェックする

- モデル更新: ベンダーからセキュリティパッチやモデルアップデートが提供される場合は速やかに適用する

まとめ

- プロンプトインジェクション対策の基本

- 入力(Prompt)、モデル(LLM)、出力(Response)の三層で防御を考える

- AIの応答に過度に依存せず、人間の承認や検証を挟む

- 具体的な防御策

- 入力バリデーション・サニタイズ、コンテクスト分離、役割指示(Role-based Prompting)

- システムメッセージの優先度設定、ガードレール(Guardrails)、パラメータ調整

- 出力段階でのフィルタリングやヒトのレビュー

- 運用上の注意

- セキュリティポリシーやガイドラインの整備

- 教育・トレーニングによる誤操作の防止

- 継続的なモニタリングとモデルアップデート

これらの対策を組み合わせて多層的に守ることで、プロンプトインジェクションのリスクを大きく抑えられます。

実装や運用ルールを整える際には、自社のビジネス特性や利用シーンに合わせてカスタマイズしてみてください。

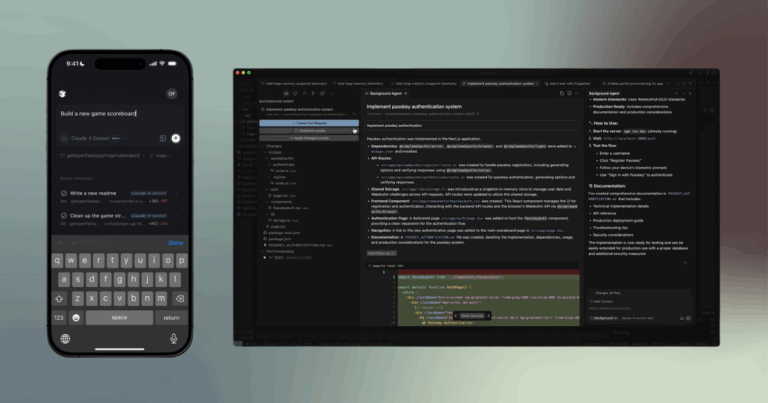

【特典PDF】対策を実務に落とし込むためのチェックリスト&フロー図

第4回の記事ではプロンプトインジェクション対策として、入力・モデル・出力の三層アプローチやガードレール設定などを紹介しました。

「対策チェックリスト&実装フローチャート」PDFでは、

- まず押さえておきたい項目を網羅した総合チェックリスト

- 開発から運用までの流れを可視化したフローチャート

- サンプルコードや設定例

など、現場ですぐ使える資料をまとめています。

▼PDF特典のダウンロードはこちら

次回予告

次回(第5回)は、「運用・管理編:ビジネスで取り入れる際の注意点」をテーマに、組織全体でプロンプトインジェクション対策を進めるための体制づくりやコスト管理など、ビジネス視点からのヒントをさらに深掘りしていきます。AIセキュリティの運用を検討している方は、ぜひ続けてご覧ください!

本連載「AI時代の新たな脅威を防げ!プロンプトインジェクション対策最前線」は、今後も最新情報と実践的なノウハウをお届けします。引き続きお読みいただき、プロンプトインジェクションへの知見を深めていきましょう。