DeepSeekは2023年に設立された中国発のAI企業で、高性能かつコストパフォーマンスに優れた大規模言語モデル(LLM)を提供しています。

「最新のAI技術を導入したいけれど、高額な導入コストや専門知識の壁が心配…」とお悩みの方も多いのではないでしょうか。DeepSeekのモデルはオープンソースとして公開されており、研究からビジネス利用まで柔軟に対応できる点が大きな魅力です。

本記事では、DeepSeekが提供する主力モデルや技術的な特徴、そして気になる課題や今後の展望について、初心者の方でも理解しやすいように解説します。ぜひ最後まで読んでみてくださいね。

DeepSeekとは?

ここでは、2023年に設立された中国のAI企業「DeepSeek」について、初心者の方にもわかりやすく解説します。DeepSeekは大規模言語モデル(LLM)の開発に注力しており、コスト効率の高いオープンソースモデルを提供することで注目を集めている企業です。研究目的だけでなく、商用利用も可能なライセンス形態を採用しているため、多くの開発者や企業から評価されています。

DeepSeekの概要

DeepSeekは、元ByteDanceのAI研究者である趙永剛(Zhao Yonggang)氏が創業し、AIモデルのコストパフォーマンスと効率的なトレーニング手法で業界内外から高く評価されています。彼らが目指すのは、AI技術の「民主化」です。つまり、誰もが高度なAIを利用できるようにすることを目標としています。

DeepSeekの主なモデルと技術的特徴

ここからは、DeepSeekが開発している代表的なモデルを一覧でご紹介します。

1. DeepSeek-V3

DeepSeekのフラッグシップモデルであるDeepSeek-V3は、6710億パラメータという大規模さが特徴です。

- アーキテクチャ: Mixture-of-Experts(MoE)

トークンごとに370億パラメータを動的に活性化させる設計で、計算効率を大幅に向上しています。 - 技術革新

- Multi-Head Latent Attention (MLA): 推論時のメモリ使用量を抑え、精度を高める注意機構。

- Multi-Token Prediction (MTP): 一度に複数のトークンを予測できるため、推論速度が向上。

- FP8混合精度トレーニング: メモリ効率を高め、トレーニングコストを抑制。

DeepSeek-V3の性能とコスト

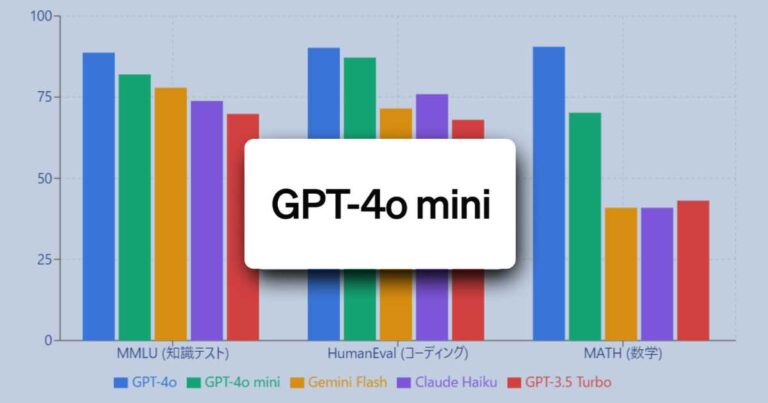

- 性能: GPT-4oやClaude 3.5 Sonnetと同等クラスの精度を誇り、数学的推論・コーディング・中国語処理などで優れた結果を示します。

- コスト効率: トレーニングコストは約557万ドルと、他社の大規模モデルと比較して非常に低コストです。

- APIとオープンソース: MITライセンスで公開されており、研究・商用利用ともに柔軟に対応しています。API料金は2025年2月8日以降、入力100万トークンあたり0.27ドル、出力100万トークンあたり1.10ドルです。

2. DeepSeek-V2

Deep-Seek-V2はDeepSeek-V3の前身モデルで、236億パラメータを持つMoEアーキテクチャを採用しています。推論時には21億パラメータのみを使用する設計で、計算コストを大幅に削減しました。価格競争を引き起こしたモデルとしても知られています。

3. DeepSeek-Coder

Deep-Seek-Coderはコード生成に特化したモデルで、複数のプログラミング言語に対応しています。HumanEvalなどのベンチマークで高いスコアを記録し、開発者向けのコーディング支援ツールとして活躍しています。

4. DeepSeek R1-Lite-Preview

DeepSeek R1-Lite-Previewは論理的推論や数学的推論に特化したモデルで、AIMEやMATHといったベンチマークで高い性能を誇ります。リアルタイムの問題解決能力も備えており、学術分野や高度な計算タスクに適しています。

DeepSeekモデルの技術的優位性

この章では、DeepSeekのモデルが他社のLLMと比べて優れているポイントをまとめてご紹介します。

1. 効率的なトレーニング

- Nvidia H800 GPUを使用し、わずか2か月でトレーニングを完了。

- 必要なGPU時間は2.78M時間と、他社の大規模モデル(例:MetaのLlama 3.1が30.8M時間)と比べて大幅に短縮されています。

2. 完全なオープンソース化

ソースコードがGitHubで公開されており、研究者や開発者が自由に利用・改良できる点が大きな魅力です。AI技術の「民主化」を体現していると言えるでしょう。

3. 多様な応用分野

DeepSeekのモデルは、以下のような場面で活用されています。

- コーディング支援: DeepSeek-Coderを使えば複数言語のコードを自動生成可能。

- 数学的推論: 数学競技レベルの問題にも対応できる推論能力。

- コンテンツ生成: ニュース記事やブログ、フィクションまで多岐にわたるジャンルをカバー。

- 翻訳と字幕生成: 多言語対応により、国際的なコミュニケーションをサポート。

課題と今後の展望

DeepSeekのモデルには多くの利点がありますが、いくつかの課題も残っています。

1. 英語の事実知識における弱点

英語圏の事実ベースの質問に対し、正確性がやや劣る場合があると指摘されています。

2. 日本語対応の課題

日本語入力時のIME(文字変換)に関する問題点があり、さらなる改善が求められています。

今後の展望

- AGI(汎用人工知能)の実現を目指し、技術革新と商用化戦略の拡大に力を入れる見込み。

- トレーニングデータの透明性や、多様なタスクへの対応事例の増加にも注目が集まっています。

まとめ

DeepSeekは、低コストで高性能な大規模言語モデル(LLM)を提供し、AI技術の利用ハードルを下げている注目の企業です。特にDeepSeek-V3は、Mixture-of-Experts(MoE)などの最新技術を取り入れながら、オープンソースとして公開されている点が魅力的です。

一方で、英語圏や日本語対応の課題も残っており、これらの改良が今後の普及と成功の鍵となるでしょう。「AI技術をより多くの人が簡単に使える世界を作る」という理念を掲げるDeepSeekが、どのようにこれらの課題を克服し、さらに進化していくのか、今後も目が離せません。