生成AIを活用したいけれど、セキュリティリスクが心配ではありませんか?もしかすると、まだ気づいていないセキュリティ上の潜在的な脅威が組織に潜んでいるかもしれません。

本記事では、生成AI導入に際して知っておくべき7つの主要なセキュリティリスクを詳細に解説し、それぞれに対する具体的な対策をお伝えします。

また、リスクを最小限に抑えながら、効率的かつ安全にAIを運用するための導入戦略や、最新のAIセキュリティ監査ツールの活用法もご紹介します。

生成AIの可能性を最大限に引き出しながら、組織のセキュリティを守るための知識を手に入れ、競争優位性を確保しましょう!

はじめに:なぜ生成AIのセキュリティ対策が不可欠なのか

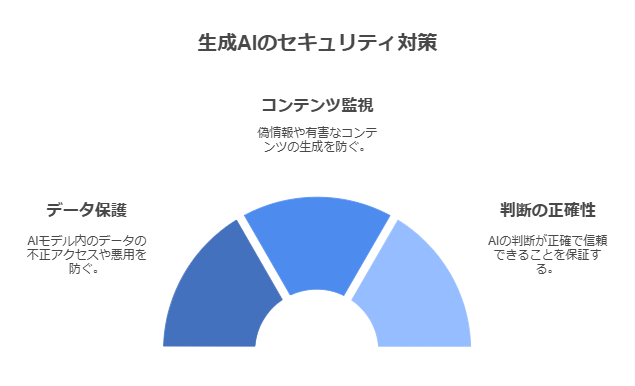

生成AIは、大規模言語モデル(LLM)や画像生成モデルなどを活用し、新規コンテンツを自動的に創出する技術です。業務効率化、イノベーション創出、顧客対応の質向上など、多大なメリットを提供する一方、その背後には以下のようなリスクが潜んでいます。

- データ流出や不正利用:AIモデルに格納・学習させるデータが、外部・内部からの攻撃で悪用される可能性

- 有害コンテンツの生成:フェイクニュースや差別的表現、有害情報などの不適切なアウトプット

- 判断ミスによる事故:AIが誤った判断を下すことで、安全性や社会的信用を損なう恐れ

これらのリスクを軽視すると、法的制裁やブランド毀損、顧客離れを招く可能性があります。組織としては、あらかじめリスク対策を講じることで、生成AIの能力を安心して活用できる環境づくりが求められます。

生成AIの7大セキュリティリスクと具体的対策

生成AIの活用が広がる中、セキュリティリスクへの対策は不可欠です。ここでは、不正アクセスによる情報漏洩、有害コンテンツ生成、サイバー攻撃、差別的出力、プロンプトインジェクション、著作権侵害、AIの判断ミスという7つの主要リスクを取り上げます。

それぞれのリスクの具体的な内容と、効果的な対策方法をわかりやすく解説していきます。

1. 不正アクセスによる機密情報漏洩

生成AIシステムへの不正アクセスは、企業秘密や個人情報の流出という深刻な問題を引き起こす可能性があります。AIモデルには大量のデータが学習されているため、攻撃者にとって魅力的な標的となります。

外部からの侵入を防ぐには、最新のセキュリティ対策技術の導入が不可欠です。

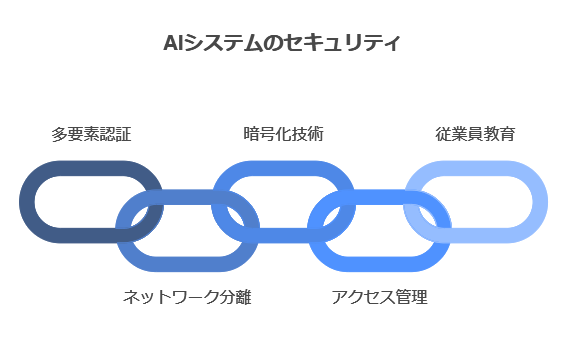

主な対策技術

- 多要素認証の導入

- ネットワークの分離とファイアウォールの強化

- 暗号化技術の活用

- 定期的なセキュリティ監査の実施

内部関係者による意図的な情報漏洩も見過ごせません。適切なアクセス権限管理と監視体制の構築が重要です。具体的には、必要最小限のアクセス権限付与、ログ監視、定期的な権限見直しなどが効果的です。

さらに、従業員への継続的なセキュリティ教育も欠かせません。技術的対策だけでなく、人的要因によるリスクも最小限に抑える必要があります。

2. 悪意ある入力による有害コンテンツ生成

生成AIに悪意ある入力を行うことで、有害なコンテンツが生成されるリスクがあります。プロンプトインジェクションなどの手法を用いて、AIに不適切な指示を与えることで、攻撃者の意図した有害な出力を引き出すことが可能です。

このような有害コンテンツの生成は、フェイクニュースの拡散や個人・組織への誹謗中傷など、深刻な社会的影響をもたらす可能性があります。企業はAIシステムの運用に関して法的・倫理的責任を負う可能性があるため、対策が不可欠です。

有害コンテンツ生成を防ぐための技術的対策としては、以下が挙げられます。

- 入力フィルタリング:不適切な単語や文字列を検出し、ブロックする

- コンテンツモデレーション:AIの出力を人間がチェックし、問題のある内容を排除する

- セーフティ機能の実装:AIモデルに倫理的な制約を組み込み、有害な出力を抑制する

これらの対策を組み合わせることで、悪意ある入力によるリスクを軽減できます。ただし、完全な防御は困難なため、継続的な監視と改善が重要です。

3. AIモデルの脆弱性を狙ったサイバー攻撃

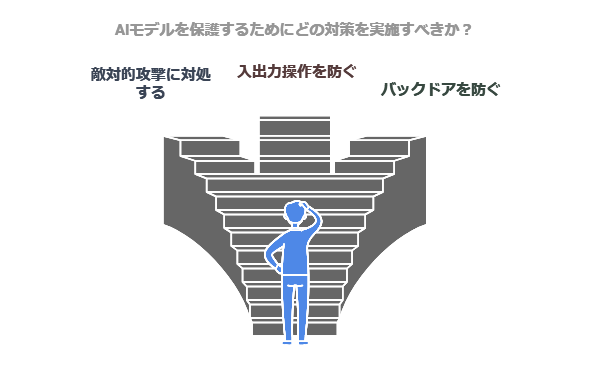

AIモデルの脆弱性を狙ったサイバー攻撃は、生成AIのセキュリティリスクの中でも特に注意が必要です。攻撃者はAIモデルの学習データや構造を探る敵対的攻撃を仕掛け、機密情報を抽出しようと試みます。

また、モデル推論時の入出力を巧妙に操作し、意図しない動作を引き起こす攻撃も懸念されます。これらの攻撃は、AIシステムの信頼性を損なう可能性があります。

主な攻撃パターンと対策

AIモデルを狙った攻撃には、以下のようなパターンがあります。それぞれに対する効果的な対策も併せて紹介します。

| 攻撃パターン | 対策 |

|---|---|

| 敵対的攻撃 | 入力データの検証強化、モデルの堅牢性向上 |

| 入出力操作 | 異常検知システムの導入、出力のサニタイズ |

| バックドア悪用 | 定期的なモデル監査、セキュリティテスト実施 |

これらの対策を適切に実施することで、AIモデルの脆弱性を狙ったサイバー攻撃のリスクを大幅に軽減できます。ただし、攻撃手法は日々進化するため、常に最新の脅威情報を収集し、対策を更新し続けることが重要です。

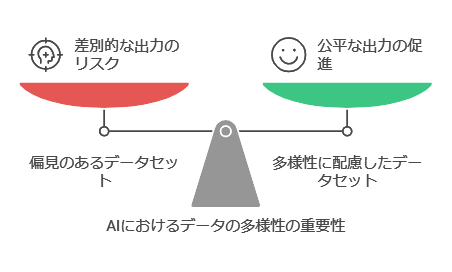

4. 学習データの偏りによる差別的出力

生成AIの学習データに含まれる偏見や固定観念が、AIの出力に反映されてしまう問題が指摘されています。例えば、特定の人種や性別に対する偏見が含まれたデータで学習したAIは、差別的な表現や判断を生成する可能性があります。

この問題に対処するには、多様性に配慮したデータセットの構築が不可欠です。さらに、AIの出力結果に対して公平性テストを実施し、偏りがないか定期的に検証することが重要です。

差別的出力を防ぐ具体的な対策

- 多様な背景を持つ人々からデータを収集し、バランスの取れたデータセットを作成する

- AIモデルの学習前に、データセットの偏りを分析・修正する

- AIの出力結果を人間が確認し、必要に応じて修正を加える体制を整える

これらの対策を講じることで、AIによる差別的な出力のリスクを大幅に軽減できます。ただし、完全な解決は難しいため、AIの出力を鵜呑みにせず、人間による適切な判断と管理が常に必要です。

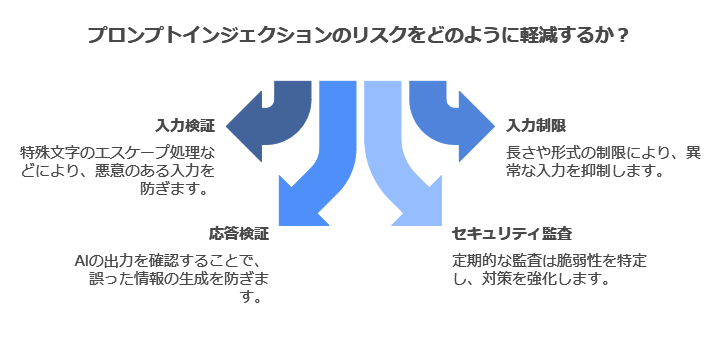

5. プロンプトインジェクションによる誤動作

プロンプトインジェクションは、AIモデルの動作を悪意ある入力で操作する手法です。通常のプロンプトに巧妙に細工を加え、AIに意図しない動作をさせることが可能です。

この攻撃により、AIが誤った情報や有害なコンテンツを生成するリスクが生じます。例えば、セキュリティ設定を無視させたり、機密情報を漏洩させたりする危険性があります。

対策として、入力の厳密な検証とサニタイズ処理が重要です。具体的には以下の方法が効果的です。

- 特殊文字や制御文字のエスケープ処理

- 入力の長さや形式の制限

- AIモデルの応答内容の検証

また、AIシステムの設計段階から、プロンプトインジェクション対策を組み込むことが望ましいでしょう。定期的なセキュリティ監査や、最新の攻撃手法に関する情報収集も欠かせません。

これらの対策を適切に実施することで、プロンプトインジェクションのリスクを大幅に軽減できます。

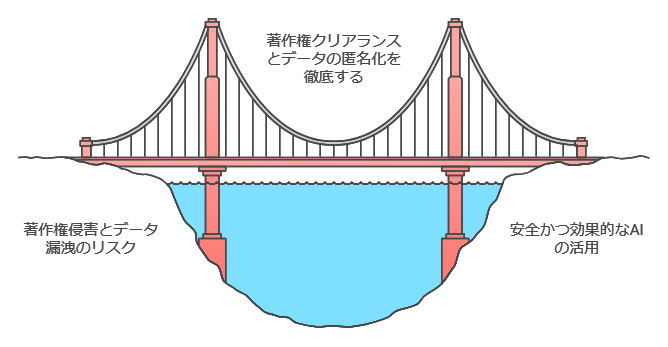

6. 著作権侵害や個人情報流出のリスク

生成AIの利用には、著作権侵害や個人情報流出のリスクが伴います。AIが学習データに含まれる著作物を模倣し、権利者の許可なく類似コンテンツを生成する可能性があります。企業はこれらのコンテンツを使用した場合、法的責任を問われる恐れがあります。

また、学習データに含まれる個人情報が、AIモデルを通じて漏洩するリスクも存在します。これを防ぐため、データの匿名化や暗号化が重要です。

さらに、AIモデルからの情報抽出攻撃により、機密データが流出する危険性もあります。

対策のポイント

これらのリスクに対し、以下の対策が有効です。

- 著作権クリアランスの徹底と、生成コンテンツの二次利用ポリシー策定

- 学習データの匿名化処理と、個人情報を含まないデータセットの使用

- 差分プライバシーなどのモデル保護技術の導入

適切な対策を講じることで、安全かつ効果的に生成AIを活用できます。常に最新のセキュリティ動向に注意を払い、リスク管理を怠らないことが重要です。

7. AIの判断ミスによる重大事故や損失

AIの判断ミスは、時として重大な事故や損失を引き起こす可能性があります。特に医療診断や金融取引などの重要な分野では、AIの誤った判断が深刻な結果を招く恐れがあります。

そのため、AIの判断に全面的に依存するのではなく、人間による監視と検証を組み合わせることが不可欠です。例えば、AIが提案した診断結果や投資判断を、経験豊富な専門家がダブルチェックする体制を整えることで、リスクを大幅に軽減できます。

自動運転車や産業用ロボットの分野でも、AIの誤作動は人身事故や設備損傷につながる可能性があります。これらのシステムには、AIの判断に異常が検出された場合に即座に安全モードに切り替わる機構を組み込むなど、多重の安全対策が求められます。

AIの予測ミスによる影響

さらに、AIの予測ミスが大規模な経済損失や社会的混乱を引き起こすシナリオも考えられます。例えば、天候予測や株価予測の大幅な誤りは、広範囲に影響を及ぼす可能性があります。

このようなリスクに対しては、複数のAIシステムによるクロスチェックや、人間の専門家との協働による判断プロセスの構築が効果的です。AIの能力を最大限に活用しつつ、その限界を理解し、適切な監視と制御を行うことが、安全な AI 活用の鍵となります。

安全性と効率性を両立!生成AI導入の最適戦略

生成AIの導入には、リスクと効率性のバランスが不可欠です。本セクションでは、安全かつ効果的な活用戦略をご紹介します。リスク評価に基づくモデル選定、組織全体のガイドライン策定、従業員教育、人間による最終判断の徹底、そして継続的な改善サイクルの構築。これらの要素を組み合わせることで、生成AIの潜在力を最大限に引き出せます。

リスク評価に基づくAIモデル選定プロセス

リスク評価に基づくAIモデル選定は、生成AI導入の成否を左右する重要なプロセスです。まず、組織の特性や業務内容に応じたリスク評価基準を設定しましょう。セキュリティ、パフォーマンス、コストなど、多角的な観点から評価項目を定義します。

次に、候補となる複数のAIモデルを選定基準に基づいて比較分析します。定量的・定性的な評価を通じて、最適なモデルを特定していきます。

| 評価項目 | 評価方法 | 重要度 |

|---|---|---|

| セキュリティ | 脆弱性診断 | 高 |

| パフォーマンス | ベンチマークテスト | 中 |

| コスト | TCO分析 | 中 |

最後に、選定したモデルの導入後も継続的なモニタリングが欠かせません。性能やリスクを定期的に評価し、必要に応じて改善や入れ替えを行う仕組みを構築しましょう。この一連のプロセスにより、組織に最適なAIモデルを選定・運用できます。

組織全体での利用ガイドライン策定

組織全体で生成AIを安全に活用するには、明確なガイドラインの策定が不可欠です。部門横断的なタスクフォースを設置し、AIの利用範囲や制限事項を包括的に定めましょう。

ガイドラインには、データセキュリティ、倫理的配慮、法令遵守などの重要な観点を盛り込む必要があります。これらを網羅したチェックリストを作成し、定期的な見直しを行うことで、常に最新の状況に対応できます。

| ガイドラインの主要項目 | 具体的な内容 |

|---|---|

| 利用可能なAIツール | 承認済みのサービスリスト |

| データ取り扱い基準 | 機密情報の入力禁止など |

| 出力内容の確認手順 | 人間による最終チェック |

さらに、従業員向けのAI利用トレーニングプログラムを開発し実施することで、ガイドラインの周知徹底と適切な運用を確保できます。定期的な研修やe-ラーニングを通じて、全従業員のAIリテラシー向上を図りましょう。

従業員向け生成AI活用・セキュリティ教育

生成AIの安全な活用には、従業員への適切な教育が欠かせません。組織全体で一貫したアプローチを取るため、包括的な教育プログラムの開発が重要です。

このプログラムでは、生成AIの基本的な仕組みや利点に加え、データ漏洩や著作権侵害などのリスクについても理解を深めます。特に機密情報の取り扱いには細心の注意が必要です。

具体的なガイドラインの策定

従業員が日々の業務で生成AIを活用する際の指針として、明確なガイドラインを策定しましょう。これには、入力してはいけない情報の種類や、出力結果の検証方法などが含まれます。

| 項目 | ガイドライン |

|---|---|

| 機密情報 | 個人情報や企業秘密は入力禁止 |

| 出力検証 | 人間による確認を必ず実施 |

| 著作権 | 引用元の確認と適切な表記 |

こうしたガイドラインを全社で共有し、定期的な研修を通じて従業員の意識を高めていくことが大切です。また、技術の進化や新たな脅威に対応するため、教育内容は常に最新のものに更新していく必要があります。

AI出力の検証と人間による最終判断の徹底

AIの出力結果を鵜呑みにせず、人間による適切な検証と判断が不可欠です。複数の専門家や部門による多角的な検証プロセスを確立し、AIの提案の信頼性と正確性を担保しましょう。

特に重要な意思決定においては、AI提案の位置づけを明確にし、最終判断は必ず人間が行う原則を徹底することが重要です。

検証プロセスの標準化

AI出力の誤りや偏見を効率的に発見・修正するため、以下のような検証プロセスを標準化することをおすすめします。

- 複数の専門家による多角的な検証

- チェックリストを用いた系統的な確認

- 人間の知見と経験に基づく総合的な判断

このプロセスを通じて、AIの長所を活かしつつ、人間ならではの洞察力や創造性を組み合わせることで、より質の高い意思決定が可能になります。

定期的に検証プロセスの有効性を評価し、必要に応じて改善を加えることで、AIと人間の協働による最適な成果を追求しましょう。

継続的なモニタリングと改善サイクルの構築

生成AIの安全な活用には、継続的なモニタリングと改善が欠かせません。定期的なシステム評価を通じて、AIの性能とリスクを把握し、セキュリティ対策の効果を測定する仕組みを構築しましょう。

インシデント発生時には迅速な対応が求められます。同時に、その経験から得られた教訓を基にセキュリティを強化するプロセスを確立することが重要です。

最新の脅威情報や技術動向を常にキャッチアップし、AIセキュリティ対策を継続的に更新・改善する体制を整えることで、長期的な安全性を確保できます。

効果的なモニタリングのポイント

以下のポイントを押さえ、効果的なモニタリングを実施しましょう。

- 定量的な指標の設定と測定

- ユーザーフィードバックの収集と分析

- 外部専門家による定期的な評価

これらの取り組みを通じて、生成AIの安全性と効率性を両立させる持続可能な運用体制を構築できます。

AIセキュリティ監査ツール5選と活用法

AIセキュリティ監査ツールの活用は、企業のデジタル資産を守る上で重要です。本セクションでは、GPT-4、IBM Watson、Microsoft Azure AI、Google Cloud AI、Symantec AIという5つの先進的なツールを紹介します。各ツールの特徴や具体的な活用法を解説し、効果的なAIセキュリティ監査の実施方法をお伝えします。

これらのツールを適切に選択・導入することで、企業のAIシステムの脆弱性を特定し、潜在的リスクを最小化できます。

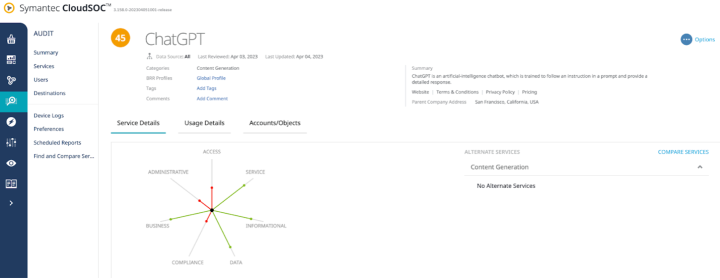

1. ChatGPT:高度な自然言語処理による監査

ChatGPTの高度な自然言語処理能力は、AIセキュリティ監査に革新をもたらしています。このツールを活用することで、AIシステムの脆弱性や潜在的リスクを詳細に分析できます。

自然言語でのセキュリティポリシーチェックが可能になり、複雑なポリシーの解釈や遵守状況の評価が容易になりました。また、コード監査の自動化により、効率的なリスク検出プロセスが実現します。

ChatGPTは模擬攻撃シナリオの生成にも活用できます。これにより、より現実的で多様な脅威に対するセキュリティ対策の評価・改善が可能になります。

ChatGPTを活用したAIセキュリティ監査の主な利点

- 複雑なセキュリティポリシーの迅速な解析と評価

- 大規模なコードベースの効率的な脆弱性スキャン

- 高度で多様な攻撃シナリオに基づく対策の検証

ChatGPTの導入により、企業は従来よりも包括的かつ効果的なAIセキュリティ監査を実施できます。ただし、結果の解釈や対策の実施には、人間の専門家による判断が不可欠です。

2. IBM Watson:企業向け包括的AI分析

IBM Watsonは、企業向けに包括的なAI分析機能を提供する強力なツールです。セキュリティリスク評価においても、その能力を存分に発揮します。

Watsonは膨大なデータを自動で分析し、セキュリティ脅威を早期に検知・予測する能力に優れています。企業内の様々なシステムやログから収集したデータを学習し、通常とは異なる不審な動きを瞬時に察知します。

AIセキュリティ監査プロセスの自動化と効率化にも大きく貢献します。例えば、以下のような活用が可能です。

- ネットワークトラフィックの異常検出と自動アラート発信

- セキュリティポリシー違反の自動チェックと報告書作成

- 脆弱性スキャンの実施と優先度付けされた対策リストの生成

これらの機能により、セキュリティチームの負担を大幅に軽減しつつ、より精度の高い監査を実現できます。IBM Watsonを導入することで、企業は常に最新のAI技術を活用した高度なセキュリティ体制を維持できるのです。

3. Microsoft Azure AI:クラウドベースの監視

Microsoft Azure AIは、クラウドベースの監視システムを提供し、AIセキュリティ管理に革新をもたらしています。このツールの最大の特徴は、リアルタイムでAI動作の異常を検知できる点です。

Azure AIは、Azure Security Centerと連携することで、AIワークロードの包括的なセキュリティ管理を実現します。これにより、複雑なAIシステムの脆弱性を効率的に特定し、迅速な対応が可能になります。

さらに、Azure Monitor Insightsを活用することで、AIモデルのパフォーマンスと潜在的リスクを可視化できます。この機能により、セキュリティチームは直感的にシステムの状態を把握し、適切な対策を講じることができます。

| 機能 | メリット |

|---|---|

| リアルタイム異常検知 | 即時の脅威対応が可能 |

| 包括的セキュリティ管理 | AIワークロード全体の保護 |

| パフォーマンス可視化 | 効率的なリスク評価と対策 |

Microsoft Azure AIは、これらの機能を統合することで、企業のAIシステムを包括的に保護し、セキュリティリスクを最小限に抑える強力なツールとなっています。

4. Google Cloud AI:大規模データセキュリティ

Google Cloud AIは、大規模データのセキュリティ管理に優れた機能を提供します。AIモデルの学習データセキュリティを強化するため、Cloud Data Loss Preventionを活用した機密情報の自動検出と匿名化が可能です。

この技術により、個人情報や機密データを含む大量のデータセットを安全に処理できます。具体的には以下のプロセスを実装します。

- 機密情報の自動スキャン

- 検出されたデータの匿名化または暗号化

- 処理済みデータの安全な保存と管理

さらに、BigQueryとCloud AIの連携により、大規模データセットのセキュリティ分析と異常検知が可能になります。機械学習アルゴリズムを用いて、通常とは異なるデータアクセスパターンや不審な挙動を検出し、潜在的なセキュリティリスクを早期に特定できます。

これらの機能を組み合わせることで、企業は大規模なAIプロジェクトを安全に推進できます。Google Cloud AIのセキュリティ機能を活用し、データ保護とイノベーションの両立を実現しましょう。

5. Symantec AI:リアルタイム脅威検知

Symantec AIは、機械学習を活用したリアルタイム脅威検知システムです。このシステムは、膨大なセキュリティデータを分析し、既知・未知の脅威をわずか数秒で特定します。

高度な検出能力と低い誤検知率が特徴で、99.9%の検知率と0.1%未満の誤検知率を実現しています。これにより、セキュリティチームの負担を大幅に軽減できます。

Symantec AI導入のポイント

Symantec AIを企業のセキュリティ体制に組み込む際は、以下の手順が効果的です。

- 既存のセキュリティインフラとの統合性を確認

- 社内データを用いた初期学習の実施

- 検知ルールのカスタマイズと定期的な更新

- セキュリティチームへの運用トレーニングの実施

導入後は、検知された脅威への迅速な対応と、システムの継続的な監視・調整が重要です。Symantec AIを活用することで、企業は常に進化するサイバー脅威に対し、より強固なセキュリティ体制を構築できます。

まとめ

生成AIの活用には大きな可能性と同時にリスクも存在します。本記事では7つの主要なセキュリティリスクとその対策を詳しく解説しました。適切な対策を講じることで、生成AIを安全かつ効果的に活用できます。

セキュリティ意識を持ちつつ、生成AIの恩恵を最大限に享受しましょう。技術の進化に伴い、新たなリスクや対策も生まれる可能性があります。常に最新情報をキャッチアップし、柔軟に対応することが重要です。